Distribución marginal

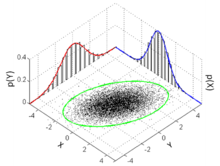

En teoría de probabilidades, la distribución marginal es la distribución de probabilidad de un subconjunto de variables aleatorias de un conjunto de variables aleatorias. La distribución marginal proporciona la probabilidad de un subconjunto de valores del conjunto sin necesidad de conocer los valores de las otras variables. Esto contrasta con la distribución condicional, que proporciona probabilidades contingentes sobre el valor conocido de otras variables.

El término variable marginal se usa para referirse a una variable del subconjunto de retenido y cuyos valores pueden ser conocidos.[1] La distribución de las variables marginales, la distribución marginal, se obtiene marginalizando sobre la distribución de variables descartadas y las variables descartadas se llaman a veces variables marginalizadas.

El caso más simple es el de dos variables aleatorias reales y para la que se conozca su distribución de probabilidad conjunta , entonces la distribución marginal de es la distribución de probabilidad de haciendo caso omiso de la información referente a . Para las variables aleatorias discretas, la ley de probabilidad marginal se escribe

donde denota la distribución conjunta de y , mientras que denota la distribución condicional de conociendo . Ésta es la lección principal del Teorema de la probabilidad total. Del mismo modo, para variables aleatorias continuas, la densidad de probabilidad marginal pX (x) verifica

donde da la distribución conjunta de y , y la distribución condicional de conociendo .

Este tipo de cálculo se produce cuando se considera el estudio de una tabla de contingencia.[1]

Referencias

- ↑ a b Trumpler and Weaver (1962), pp. 32–33.

Bibliografía

- Everitt, B. S. (2002). The Cambridge Dictionary of Statistics. Cambridge University Press. ISBN 0-521-81099-X.

- Trumpler, Robert J. and Harold F. Weaver (1962). Statistical Astronomy. Dover Publications.

Enlaces externos

- Obtención distribución marginal a partir de distribución conjunta de una variable bidimensional discreta con R-Project

Datos: Q670653

Datos: Q670653

![{\displaystyle \operatorname {P} [X=x]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ac2c698a2e23688ac8f11e09e070df32addeaa03)

![{\displaystyle \operatorname {P} [X=x]=\sum _{y}\operatorname {P} [X=x,Y=y]=\sum _{y}\operatorname {P} [X=x|Y=y]\operatorname {P} [Y=y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/455f74595d599ff47082b47ec968b7ecc018ad3a)

![{\displaystyle \operatorname {P} [X=x,Y=y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/99e312964cdd934fb23e20cdd017c6c5976b1b56)

![{\displaystyle \operatorname {P} [X=x|Y=y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/246646ecfec0bb85d5c9e03c0f82a8d7026d76a2)